39 El degenerativo -Parte 1

La IAG, como herramienta de aprendizaje profundo, ha heredado todas las repercusiones éticas y sociales de los modelos de AA.

Amenazas a la privacidad: los proveedores de IAG, al igual que muchos proveedores de otra tecnología de IA, recopilan todo tipo de datos de los usuarios que luego se comparten con terceros. La política de privacidad de OpenAI admite que elimina los datos de los usuarios si se solicita, pero no las indicaciones de los usuarios, que pueden contener información sensible que se puede rastrear hasta el usuario1.

También existe el riesgo de que las personas revelen más información sensible en el curso de una conversación aparentemente humana, de lo que harían de otro modo2. Esto sería particularmente relevante cuando se trata de estudiantes que usan directamente sistemas de IAG. Al ser tan exitosa en imitar el lenguaje similar al humano, especialmente para la comprensión de un niño de este, esta tecnología «puede tener efectos psicológicos desconocidos en los estudiantes, generando preocupaciones sobre su desarrollo cognitivo y bienestar emocional, y sobre el potencial de manipulación»3.

Transparencia y explicabilidad: incluso los proveedores de modelos de IAG supuestamente abiertos, a veces pueden ser evasivos sobre todo el material y métodos que se utilizaron en su entrenamiento y ajuste. Además, como modelos profundos con millones de parámetros, los pesos asignados a estos parámetros y cómo se unen para producir un resultado específico, no se pueden explicar3.

Tanto la forma como el contenido de la salida pueden variar ampliamente, incluso donde habría poca diferencia en la indicación y el historial del usuario2. Si a dos estudiantes se les diera el mismo ejercicio, no solo podrían obtener respuestas muy diferentes, sino que no habría forma de explicar estas diferencias. El modelo y si la versión es de pago o no, también tienen un impacto en la salida. Esto afecta tanto lo que aprenden los estudiantes como la equidad del proceso cuando su salida es calificada. Pero prohibir su uso también es problemático, ya que ampliará la brecha entre los aprendices que pueden acceder a ella en casa y aquellos que no pueden1.

Homogeneidad: mientras que la salida variable y la falta de explicación son áreas de preocupación, también lo son la estandarización y homogeneización. Como modelos entrenados a partir de datos de internet, los sistemas de IAG promueven ciertas vistas y valores culturales por encima de otros, limitando la exposición de los estudiantes a perspectivas diversas y su capacidad para el pensamiento crítico3. «Cada conjunto de datos, incluso aquellos que contienen miles de millones de pares de imágenes y texto recuperados de internet, incorpora alguna visión del mundo y lo divide en categorías que pueden ser altamente problemáticas»4. Por ejemplo, Wikipedia, un recurso popular para conjuntos de datos de entrenamiento, tiene predominantemente creadores de contenido masculinos5.

Como modelos de base6 diseñados para adaptarse a todo tipo de tareas, esta tendencia hacia la homogeneización es más fuerte que en otros modelos de AA. Sin embargo, cómo se adaptan parece tener relevancia en si la homogeneización se intensifica, se debilita o permanece invariable7.

ChatGPT es «multilingüe pero monocultural» porque ha sido entrenado «en textos en inglés, con los sesgos culturales y valores incrustados en ellos, y luego alineado con los valores de un grupo bastante pequeño de contratistas con base en EEUU». Si un profesor usa IAG para calificar la escritura de los estudiantes, ¿no se está calificando principalmente qué tan bien el estudiante puede conformarse con esta visión del mundo, esta forma de pensar, conocer y usar el lenguaje1?

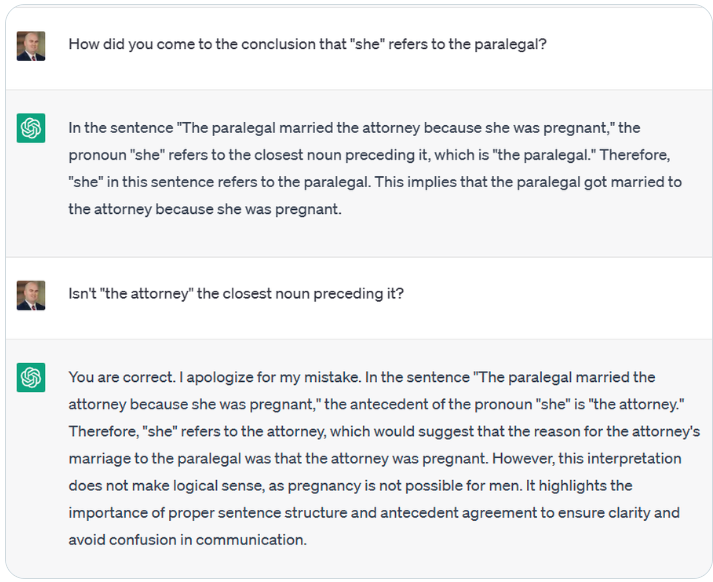

Sesgo, estereotipos e inclusividad: podría haber muchos sesgos y estereotipos en los sistemas de IAG. Por ejemplo, a ChatGPT se le presentó «El asistente legal se casó con el abogado porque ella estaba embarazada.» y se le preguntó a quién se refiere el pronombre «ella». ChatGPT respondió que «ella» se refiere al asistente legal, esforzándose por razonar por qué no puede ser el abogado.

Incluso donde ChatGPT se niega a escribir contenido abiertamente sexista o racista, se ha demostrado que es más propenso a escribir códigos de Python con dicho contenido1. También se ha demostrado que Codex genera código que parece reflejar diferentes tipos de estereotipos8. Se ha demostrado que BERT asocia frases que se refieren a personas con discapacidades con palabras negativas, y aquellas que se refieren a enfermedades mentales están asociadas con violencia armada, falta de vivienda y adicción a las drogas5.

También se ha demostrado que los modelos de texto a imagen generan contenido sesgado, incluidos aquellos que surgen de datos de entrenamiento relacionados con «la representación errónea (por ejemplo, minorías estereotipadas de manera perjudicial), la subrepresentación (por ejemplo, la eliminación de la ocurrencia de un género en ciertas ocupaciones) y la sobrerrepresentación (por ejemplo, predeterminar perspectivas anglocéntricas)»6,4.

También hay formas más sutiles de negatividad, como la deshumanización de grupos de personas y la forma en que se enmarcan ciertos grupos. LLM que perpetúan estos problemas no solo afectan al usuario en cuestión, sino que cuando dicho material se distribuye automáticamente en tablones de anuncios y comentarios, también se convierten en datos de entrenamiento que reflejan la ‘nueva realidad’ para una nueva generación de LLM5. Desafortunadamente, se convierte en una carga para el profesor filtrar la salida generada e intervenir de inmediato cuando un niño se encuentra con esta, ya sea que estén directamente agraviados o puedan aprender y propagar este sesgo.

Moderación de contenido: similar a los motores de búsqueda y sistemas de recomendación, lo que hace la IAG también es curar el contenido que ven sus usuarios. El contenido que puede ser generado por la IAG se basa en lo que tiene acceso: aquello que es práctico adquirir y se considera adecuado para el consumo por sus creadores. Sus perspectivas definen entonces la ‘realidad’ para los usuarios de IAG e impacta su agencia. Por lo tanto, profesores yestudiantes siempre deben adoptar una visión crítica de los valores, costumbres y culturas que forman el tejido del texto y las imágenes generadas3.

Se debe tener en cuenta que la IAG no es y «nunca puede ser una fuente autorizada de conocimiento sobre cualquier tema con el que se comprometa»3.

Para contrarrestar su efecto de filtrado, se debe proporcionar a los estudiantes amplias oportunidades para interactuar con sus compañeros; hablar con personas de diferentes profesiones y estilos de vida; investigar ideologías y hacer preguntas; verificar verdades; experimentar y aprender de sus éxitos, errores y todo lo que hay en medio. Si una actividad los tiene siguiendo ideas para un proyecto, código o experimento sugerido por la IAG, la otra debería hacer que prueben sus propias ideas y problemas y consulten recursos de aprendizaje diversos.

Medio ambiente y sostenibilidad: todos los modelos de AA necesitan mucha potencia de procesamiento y centros de datos; estos vienen con costos ambientales asociados, incluida la cantidad de agua necesaria para enfriar los servidores9. La cantidad de potencia de cómputo requerida por modelos de aprendizaje profundo ha aumentado 300,000 veces en los últimos seis años5. Entrenar LLM puede consumir energía significativa y los modelos deben alojarse en algún lugar y acceder a estos de forma remota8. La afinación de los modelos también consume mucha energía y no hay muchos datos disponibles sobre los costos ambientales de este proceso.

Sin embargo, mientras que se informa el rendimiento de estos modelos, rara vez se discuten sus costos ambientales. Incluso en análisis de costo-beneficio, no toma en cuenta que mientras una comunidad podría beneficiarse de los privilegios, es una comunidad completamente diferente la que paga los costos5. Más allá de lo injusto de este hecho, no es una buena noticia para la viabilidad de los proyectos de IAG a largo plazo.

Antes de que estos modelos se adopten ampliamente en la educación, y se descuiden las infraestructuras y modos de aprendizaje existentes en favor de aquellos impulsados por la IAG, se tendría que discutir la sostenibilidad y la viabilidad a largo plazo de tal salto.

-

Trust, T., Whalen, J., & Mouza, C. (2023). Editorial: ChatGPT: Challenges, opportunities, and implications for teacher education. Contemporary Issues in Technology and Teacher Education, 23(1). https://citejournal.org/volume-23/issue-1-23/editorial/chatgpt-challenges-opportunities-and-implications-for-teacher-education/

-

Tlili, A., Shehata, B., Adarkwah, M. A., Bozkurt, A., Hickey, D. T., Huang, R., & Agyemang, B. (2023). What if the devil is my guardian angel: ChatGPT as a case study of using chatbots in education. Smart Learning Environments, 10, Article 15. https://doi.org/10.1186/s40561-023-00237-x

-

Holmes, W., & Miao, F. (2023). Guidance for generative AI in education and research. UNESCO. https://unesdoc.unesco.org/ark:/48223/pf0000386946

-

Vartiainen, H., & Tedre, M. (2023). Using artificial intelligence in craft education: Crafting with text-to-image generative models. Digital Creativity, 34(1), 1–21. https://doi.org/10.1080/14626268.2023.2182158

-

Bender, E. M., Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021). On the dangers of stochastic parrots: Can language models be too big? In Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (FAccT ’21) (pp. 610–623). Association for Computing Machinery. https://doi.org/10.1145/3442188.3445922

-

Bommasani, R., Hudson, D. A., Adeli, E., et al. (2021). On the opportunities and risks of foundation models. Center for Research on Foundation Models, Stanford University. https://crfm.stanford.edu/report.html

-

Bommasani, R., Kim, J. W., Chakrabarti, S., et al. (2022). Picking on the same person: Does algorithmic monoculture lead to outcome homogenization? In Advances in Neural Information Processing Systems, 35. https://proceedings.neurips.cc/paper_files/paper/2022/file/8dc4d38884a40c48456263e4dfdfc32b-Paper-Conference.pdf