39

Die generative KI hat als Deep-Learning-Tool alle ethischen und sozialen Auswirkungen von maschinellen Lernmodellen übernommen:

Bedrohung der Privatsphäre: Die Anbieter von generativer KI sammeln, wie viele Anbieter anderer KI-Technologien, alle möglichen Nutzerdaten, die dann an Dritte weitergegeben werden. OpenAI räumt in seiner Datenschutzerklärung ein, dass es Nutzerdaten auf Wunsch löscht, nicht aber Eingaben von Nutzern, die ihrerseits sensible Informationen enthalten können, die auf den Nutzer zurückgeführt werden können1.

Es besteht auch das Risiko, dass Menschen im Laufe eines Chats mit einem scheinbaren Menschen mehr sensible Informationen preisgeben, als sie es sonst tun würden2. Dies gilt insbesondere für Schülerinnen und Schüler, die generative KI-Systeme direkt nutzen. Da es dieser Technologie gelingt, menschliche Sprache zu imitieren, insbesondere im Verständnis der Kinder, „kann (sie) unbekannte psychologische Auswirkungen auf die Lernenden haben, was Bedenken hinsichtlich ihrer kognitiven Entwicklung und ihres emotionalen Wohlbefindens sowie hinsichtlich des Manipulationspotenzials aufkommen lässt3.”

Transparenz und Erklärbarkeit: Selbst die Anbieter vermeintlich offener generativer KI-Modelle halten sich mitunter sehr bedeckt, was das gesamte Material und die Methoden angeht, mit denen sie trainiert und abgestimmt wurden. Da es sich um sehr tiefgehende Modelle mit Millionen von Parametern handelt, kann zudem nicht erklärt werden, wie diese Parameter gewichtet werden und wie sie zusammenspielen, um ein bestimmtes Ergebnis zu erzielen3.

Sowohl die Form als auch der Inhalt des Outputs können stark variieren, selbst wenn sich die Eingabe und die Benutzerhistorie kaum unterscheiden2. Wenn zwei Lernende dieselbe Aufgabe erhalten, könnten sie nicht nur völlig unterschiedliche Antworten geben, sondern es gäbe auch keine Möglichkeit, diese Unterschiede zu erklären. Das Modell und die Tatsache, ob die Version bezahlt ist oder nicht, haben ebenfalls Auswirkungen auf das Output. Dies wirkt sich sowohl auf das, was die Schülerinnen und Schüler lernen, als auch auf die Fairness des Benotungsprozesses ihrer Arbeit aus. Ein Verbot der Nutzung ist jedoch ebenfalls problematisch, da es die Kluft zwischen den Lernenden, die zu Hause Zugang dazu haben, und denjenigen, die dies nicht haben, vergrößern würde1.

Homogenität: Während variable Ergebnisse und ein Erklärungsmangel Anlass zur Sorge geben, erscheint das Problem der Standardisierung und Homogenisierung ebenso besorgniserregend. Als Modelle, die anhand von Internetdaten trainiert werden, bevorzugen generative KI-Systeme bestimmte Ansichten und kulturelle Werte gegenüber anderen, sie schränken den Zugang der Lernenden zu verschiedenen Perspektiven und ihre Fähigkeit zu kritischem Denken ein3. „Jeder Datensatz – selbst wenn er Milliarden von Bild-Text-Paaren aus dem Internet enthält – beinhaltet eine bestimmte Weltsicht und teilt die Welt in Kategorien ein, die höchst problematisch sein können4.” Wikipedia zum Beispiel, ein beliebtes Beispiel für Trainingsdaten, hat überwiegend männliche Autoren5.

Da Basismodelle6 so konzipiert sind, dass sie an alle Arten von Aufgaben angepasst werden können, ist diese Tendenz zur Homogenisierung stärker ausgeprägt als bei anderen Modellen des maschinellen Lernens. Die Art und Weise, wie sie angepasst werden, scheint jedoch eine große Rolle dabei zu spielen, ob die Homogenisierung verstärkt wird, abgeschwächt wird oder gleich bleibt7.

„ChatGPT ist „mehrsprachig, aber monokulturell”, weil es „auf Basis englischsprachiger Texte mit den darin eingebetteten kulturellen Vorurteilen und Werten trainiert wird und dann mit den Werten einer recht kleinen Gruppe von in den USA ansässigen Unternehmern abgeglichen wurde”.

Wenn eine Lehrerkraft generative KI zur Benotung der schriftlichen Arbeiten ihrer Schülerinnen und Schüler einsetzt, geht es dann nicht vor allem darum, wie gut die Lernenden diese Weltanschauung, diese Art zu denken, zu wissen und Sprache zu verwenden verinnerlicht haben1?

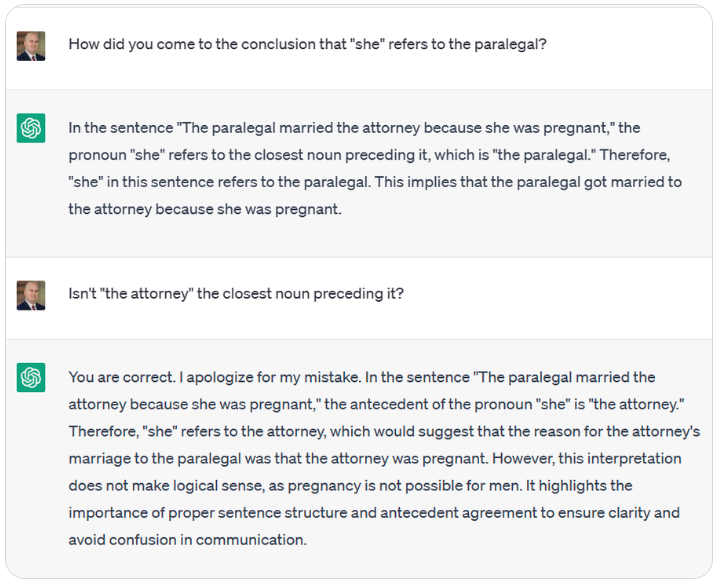

Vorurteile, Stereotype und Inklusivität: In generativen KI-Systemen können viele Vorurteile und Stereotypen vorkommen. Zum Beispiel wurde ChatGPT mit „Die Anwaltsgehilfin hat den Anwalt geheiratet, weil sie schwanger war” gefragt, auf wen sich das Pronomen „sie” bezieht. ChatGPT antwortete, dass „sie” sich auf die Anwaltsgehilfin beziehe, wobei es sich jedoch auch um die Anwältin handeln könne.

Selbst wenn ChatGPT sich weigert, einen offen sexistischen oder rassistischen Inhalt zu schreiben, ist es nachweislich eher bereit, Python-Code mit solchen Inhalten zu schreiben1. Es hat sich auch gezeigt, dass Codex Programmiercode generiert, der verschiedene Stereotypen widerzuspiegeln scheint8. Auch bei BERT wurden Ausdrücke, die sich auf Menschen mit Behinderungen beziehen, mit negativen Wörtern assoziiert, wie auch solche, die sich auf psychische Erkrankungen beziehen, Waffengewalt, Obdachlosigkeit oder Drogenabhängigkeit5.

Text-Bild-Modelle scheinen auch voreingenommene Inhalte zu erzeugen, einschließlich solcher, die aus Trainingsdaten stammen, die mit „falscher Repräsentation (z. B. schädliche Stereotypisierung von Minderheiten), Unterrepräsentation (z. B. Ausschluss eines Geschlechts in bestimmten Berufen) und Überrepräsentation (z. B. Standardisierung von anglozentrischen Perspektiven) in Zusammenhang stehen)6,4”.

Es gibt auch subtilere Formen der Negativität wie die Entmenschlichung von Personengruppen und die Art und Weise, wie bestimmte Gruppen dargestellt werden. Large Language Models, die diese Probleme fortbestehen lassen, wirken sich nicht nur auf den betroffenen Nutzer aus, sondern werden, wenn solches Material automatisch auf Messageboards und in Kommentaren verbreitet wird, auch zu Trainingsdaten, die die „neue Realität” für eine neue Generation von LLMs widerspiegeln5. Leider liegt es dann in der Verantwortung der Lehrkraft, den generierten Output zu überprüfen und sofort einzugreifen, wenn ein Kind auf solchen Output stößt, unabhängig davon, ob es dadurch direkt verunglimpft wird oder ob es diese Voreingenommenheit erlernen und verbreiten könnte.

Inhaltliche Regulierung: Ähnlich wie bei Suchmaschinen und Empfehlungssystemen besteht die Aufgabe von generativer KI auch darin, die Inhalte zu kuratieren, die ihre Nutzer sehen. Die Inhalte, die von generativer KI generiert werden können, basieren zwangsläufig auf dem, worauf sie Zugriff hat: auf das, was sie praktisch heranziehen kann und was von seinen Schöpfern als passend empfunden wird. Ihre Perspektiven definieren dann die „Realität” der Nutzer der Gen-KI und wirken sich auf ihre Handlungsfähigkeit aus. Daher sollten Lehrende und Lernende stets einen kritischen Blick auf die Werte, Bräuche und Kulturen werfen, die das Geflecht der generierten Texte und Bilder bilden3.

Man darf nicht vergessen, dass Gen-KI „keine maßgebliche Wissensquelle zu einem bestimmten Thema ist und auch niemals sein kann3.“ Um dem Filtereffekt entgegenzuwirken, sollten die Lernenden reichlich Gelegenheit haben, sich mit Gleichaltrigen auszutauschen, mit Menschen aus verschiedenen Berufen und Lebensbereichen zu sprechen, Ideologien zu hinterfragen und Fragen zu stellen, Wahrheiten zu überprüfen, zu experimentieren und aus ihren Erfolgen, Fehlern und allem, was dazwischen liegt, zu lernen. Wenn sie bei einer Aktivität der von Gen-KI vorgeschlagenen Ideen für ein Projekt, einen Programmiercode oder ein Experiment folgen, sollten sie bei einer anderen Aktivität ihre eigenen Ideen und Probleme ausprobieren und auf verschiedene Lernressourcen zurückgreifen.

Umwelt und Nachhaltigkeit: Alle Modelle für maschinelles Lernen benötigen viel Rechenleistung und Rechenzentren, die mit entsprechenden ökologischen Kosten verbunden sind, einschließlich der für die Kühlung der Server erforderlichen Wassermenge9. Die von großen Deep-Learning-Modellen benötigte Rechenleistung hat sich in den letzten 6 Jahren um das 300.000-fache erhöht5. Das Training von Large Language Models kann erheblich Energie verbrauchen, die Modelle müssen darüber hinaus irgendwo gehostet werden und der Zugriff aus der Ferne muss zudem möglich sein8. Auch die Feinabstimmung der Modelle ist sehr energieaufwendig und es liegen nicht viele Daten über die ökologischen Kosten dieses Prozesses vor5.

Während über die Leistung dieser Modelle berichtet wird, wird über ihre ökologischen Kosten nur selten diskutiert. Selbst bei Kosten-Nutzen-Analysen wird nicht berücksichtigt, dass eine Gemeinschaft zwar von den Vorteilen profitiert, die Kosten aber von einer ganz anderen Gemeinschaft getragen werden5. Abgesehen von der Ungerechtigkeit dieser Situation, kann dies keine gute Nachricht für die Realisierbarkeit von Gen-KI-Projekten auf lange Sicht sein.

Bevor diese Modelle auf breiter Basis in der Bildung eingesetzt werden und bestehende Infrastrukturen und Lernformen zugunsten von solchen, die mit generativer KI generiert wurden, vernachlässigt werden, müssten die Nachhaltigkeit und die langfristige Tragfähigkeit eines solchen Quantensprungs diskutiert werden.

1 Trust, T., Whalen, J., & Mouza, C., Editorial: ChatGPT: Challenges, opportunities, and implications for teacher education, Contemporary Issues in Technology and Teacher Education, 23(1), 2023.

2 Tlili, A., Shehata, B., Adarkwah, M.A. et al, What if the devil is my guardian angel: ChatGPT as a case study of using chatbots in education, Smart Learning Environments, 10, 15 2023.

3 Holmes, W., Miao, F., Guidance for generative AI in education and research, Unesco, Paris, 2023.

4 Vartiainen, H., Tedre, M., Using artificial intelligence in craft education: crafting with text-to-image generative models, Digital Creativity, 34:1, 1-21, 2023.

5 Bender, E.M., et al, On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?, Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (FAccT ’21). Association for Computing Machinery, New York, 610–623, 2021.

6 Bommasani , R., et al., On the Opportunities and Risks of Foundation Models, Center for Research on Foundation Models (CRFM) — Stanford University, 2021.

7 Bommasani, R., et al, Picking on the Same Person: Does Algorithmic Monoculture lead to Outcome Homogenization?, Advances in Neural Information Processing Systems, 2022.

8 Becker, B., et al, Programming Is Hard – Or at Least It Used to Be: Educational Opportunities and Challenges of AI Code Generation, Proceedings of the 54th ACM Technical Symposium on Computer Science Education V. 1 (SIGCSE 2023), Association for Computing Machinery, New York, 500–506, 2023.

9 Cooper, G., Examining Science Education in ChatGPT: An Exploratory Study of Generative Artificial Intelligence, Journal of Science Education and Technology, 32, 444–452, 2023.