17

La progettazione e l’implementazione di un progetto incentrato sui dati potrebbe essere suddivisa in 6 fasi. Le fasi si susseguono e l’intero processo può essere ripetuto più volte per ottenere il risultato desiderato.

Per essere efficaci in classe, i team multidisciplinari con insegnanti, esperti pedagogici e informatici dovrebbero essere coinvolti in ogni fase del processo1. Gli esperti umani sono necessari per identificare l’esigenza e progettare il processo, progettare e preparare i dati, selezionare gli algoritmi di ML, interpretare criticamente i risultati e pianificare l’utilizzo dell’applicazione2.

1) Comprendere il contesto educativo

Il primo passo nella progettazione di uno strumento AIED è la comprensione delle esigenze della classe. Una volta fissati gli obiettivi, bisogna capire come raggiungerli: quali fattori considerare e quali ignorare. Qualsiasi soluzione basata sui dati è orientata verso fenomeni che possono essere facilmente calcolati e standardizzati3. Pertanto, ogni decisione deve essere discussa dagli insegnanti che utilizzeranno lo strumento, dagli esperti di pedagogia che possono garantire che tutte le decisioni siano fondate su una teoria comprovata e dagli informatici che comprendono il funzionamento degli algoritmi.

Il primo passo nella progettazione di uno strumento AIED è la comprensione delle esigenze della classe. Una volta fissati gli obiettivi, bisogna capire come raggiungerli: quali fattori considerare e quali ignorare. Qualsiasi soluzione basata sui dati è orientata verso fenomeni che possono essere facilmente calcolati e standardizzati3. Pertanto, ogni decisione deve essere discussa dagli insegnanti che utilizzeranno lo strumento, dagli esperti di pedagogia che possono garantire che tutte le decisioni siano fondate su una teoria comprovata e dagli informatici che comprendono il funzionamento degli algoritmi.

Le prime due fasi sono molto complicate, poiché ciò che è possibile fare dipende anche dai dati disponibili2. Inoltre, la progettazione di strumenti educativi è soggetta a leggi che impongono restrizioni sull’uso dei dati e sui tipi di algoritmi che possono essere utilizzati.

2) Comprendere i dati

Una volta identificati gli obiettivi e i fattori che vi contribuiscono, l’attenzione si sposta sui dati necessari, sulle modalità di approvvigionamento e di etichettatura, sulla gestione della privacy e sulla misurazione della qualità dei dati3. Affinché un’applicazione di apprendimento automatico abbia successo, i dataset devono essere sufficientemente grandi, diversificati e ben etichettati.

L’apprendimento automatico (ML) richiede dati per addestrare il modello e dati su cui lavorare o fare previsioni. Per alcuni compiti di ML, come il riconoscimento dei volti e degli oggetti, sono già disponibili molti database pubblici e privati per l’addestramento.

Se non sono già disponibili in forma utilizzabile, è possibile che i dataset esistenti debbano essere aggiunti o rietichettati per adattarsi alle esigenze del progetto. In caso contrario, potrebbe essere necessario creare ed etichettare da zero set di dati dedicati. Anche le tracce digitali generate dallo studente durante l’utilizzo di un’applicazione potrebbero essere utilizzate come una delle fonti di dati.

In ogni caso, i dati e le caratteristiche rilevanti per il problema devono essere accuratamente identificati2. Le caratteristiche irrilevanti o ridondanti possono spingere un algoritmo a trovare falsi modelli e influenzare le prestazioni del sistema2. Poiché la macchina può trovare modelli solo nei dati che le vengono forniti, la sceltadel dataset definisce implicitamente anche il problema4. Se sono disponibili molti dati, è necessario selezionarne un sottoinsieme con l’aiuto di tecniche statistiche e verificare i dati per evitare errori e distorsioni.

Come esempio di dati di addestramento errati, in una vicenda risalente agli albori della computer vision, un modello fu addestrato a discriminare tra immagini di carri armati russi e americani. Si scoprì in seguito che la sua elevata precisione era dovuta al fatto che i carri armati russi erano stati fotografati in una giornata nuvolosa e quelli americani in una giornata di sole4.

Pertanto, il dataset scelto deve essere verificato per la sua qualità, tenendo conto del motivo per cui è stato creato, cosa contiene, quali sono i processi utilizzati per la raccolta, la pulizia e l’etichettatura, la distribuzione e la manutenzione4. Le domande chiave da porre sono I dataset sono adatti agli scopi per cui sono stati concepiti? e I dataset contengono rischi nascosti che possono rendere i modelli distorti o discriminatori3?

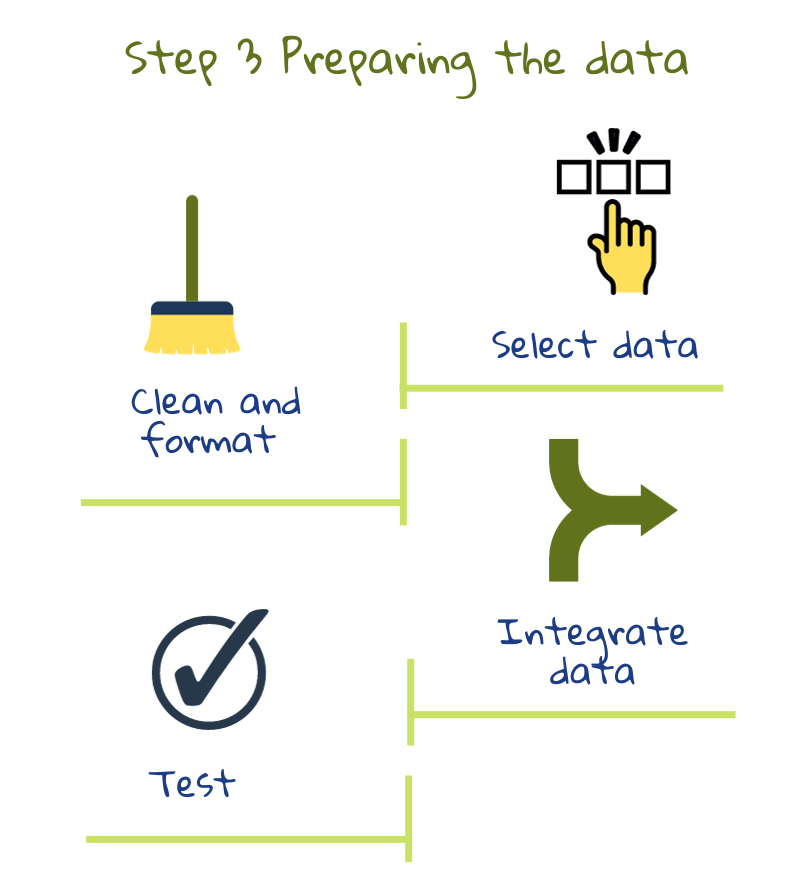

3) Preparare i dati

La preparazione dei dati comporta la creazione di dataset unendo i dati disponibili in luoghi diversi, correggendo le incongruenze (per esempio, alcuni punteggi dei test potrebbero essere su una scala da 1 a 10, mentre altri sono dati in percentuale) e cercando valori mancanti o estremi. Si possono poi eseguire test automatizzati per verificare la qualità dei dataset. Ciò include il controllo di eventuali fughe di notizie sulla privacy e di correlazioni o stereotipi imprevisti2. In questa fase, i dataset possono anche essere suddivisi in dataset di allenamento e di test. Il primo viene utilizzato per addestrare il modello e il secondo per verificarne le prestazioni. Eseguire un test sul dataset di addestramento sarebbe come distribuire il foglio d’esame il giorno prima per i compiti a casa: la prestazione dello studente all’esame non indicherà la sua comprensione2.

4) Modellazione

In questa fase, gli algoritmi vengono utilizzati per estrarre schemi dai dati e creare modelli. Di solito vengono testati diversi algoritmi per vedere quale funziona meglio. Questi modelli possono poi essere utilizzati per fare previsioni su nuovi dati.

In questa fase, gli algoritmi vengono utilizzati per estrarre schemi dai dati e creare modelli. Di solito vengono testati diversi algoritmi per vedere quale funziona meglio. Questi modelli possono poi essere utilizzati per fare previsioni su nuovi dati.

Nella maggior parte dei progetti, i modelli iniziali rivelano problemi nei dati che richiedono un passaggio continuo tra le fasi 2 e 32. Finché esiste una forte correlazione tra le caratteristiche dei dati e il valore di uscita, è molto probabile che un algoritmo di apprendimento automatico generi buone previsioni.

Questi algoritmi utilizzano tecniche statistiche e di calcolo avanzate per elaborare i dati. I programmatori devono regolare le impostazioni e provare diversi algoritmi per ottenere i risultati migliori. Prendiamo un’applicazione che rileva gli imbrogli. Un falso positivo si ha quando viene segnalato uno studente che non ha imbrogliato. Un falso negativo è quando uno studente che imbroglia non viene segnalato. I progettisti del sistema possono mettere a punto il modello per ridurre al minimo i falsi positivi, in cui alcuni comportamenti di imbroglio potrebbero essere ignorati, o i falsi negativi, in cui anche i casi dubbi vengono segnalati.5 La messa a punto (tuning) dipende quindi da ciò che vogliamo che il sistema faccia.

5) Valutazione

Durante la fase di modellazione, ogni modello può essere messo a punto per l’accuratezza della previsione sul dataset di addestramento. I modelli vengono poi testati sul dataset di prova e viene scelto un modello da utilizzare. Questo modello viene valutato anche in base a come risponde alle esigenze educative: gli obiettivi stabiliti nella fase 1 sono stati raggiunti? Ci sono problemi imprevisti? La qualità è buona? Si può migliorare o fare qualcosa in un altro modo? È necessaria una riprogettazione? L’obiettivo principale è decidere se l’applicazione può essere utilizzata nelle scuole. In caso contrario, si ricomincia l’intero processo.2

Durante la fase di modellazione, ogni modello può essere messo a punto per l’accuratezza della previsione sul dataset di addestramento. I modelli vengono poi testati sul dataset di prova e viene scelto un modello da utilizzare. Questo modello viene valutato anche in base a come risponde alle esigenze educative: gli obiettivi stabiliti nella fase 1 sono stati raggiunti? Ci sono problemi imprevisti? La qualità è buona? Si può migliorare o fare qualcosa in un altro modo? È necessaria una riprogettazione? L’obiettivo principale è decidere se l’applicazione può essere utilizzata nelle scuole. In caso contrario, si ricomincia l’intero processo.2

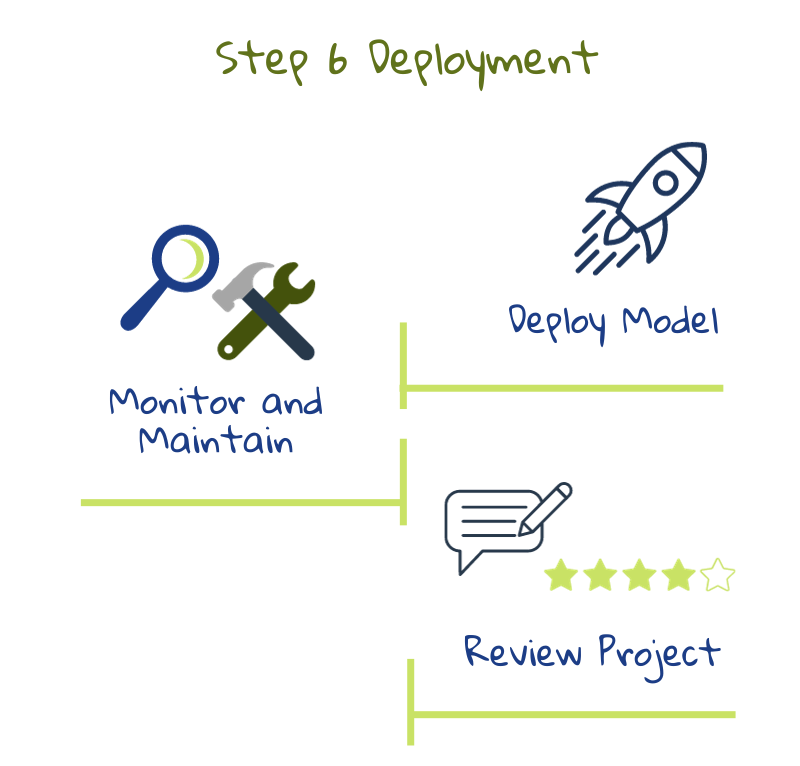

6) Implementazione (deployment)

La fase finale di questo processo consiste nel vedere come integrare l’applicazione basata sui dati con il sistema scolastico per ottenere i massimi benefici, sia per quanto riguarda l’infrastruttura tecnica che le pratiche didattiche.

La fase finale di questo processo consiste nel vedere come integrare l’applicazione basata sui dati con il sistema scolastico per ottenere i massimi benefici, sia per quanto riguarda l’infrastruttura tecnica che le pratiche didattiche.

Anche se viene dato come passo finale, l’intero processo è iterativo. Dopo l’implementazione, il modello deve essere rivisto regolarmente per verificare se è ancora pertinente al contesto. Le esigenze, i processi o le modalità di acquisizione dei dati potrebbero cambiare, influenzando l’output del sistema. Pertanto, l’applicazione deve essere rivista e aggiornata quando necessario. Il sistema deve essere monitorato costantemente per verificarne l’impatto sull’apprendimento, l’insegnamento e la valutazione.6

Le Linee guida etiche sull’uso dell’IA e dei dati per gli educatori sottolineano che la scuola dovrebbe essere in contatto con il fornitore di servizi di IA per tutto il ciclo di vita del sistema di IA, anche prima dell’implementazione. Dovrebbe richiedere una documentazione tecnica chiara e chiedere chiarimenti sui punti poco chiari. È necessario stipulare un accordo per l’assistenza e la manutenzione e accertarsi che il fornitore abbia rispettato tutti gli obblighi di legge6.

Nota: Sia le fasi qui elencate che l’illustrazione sono adattate alle fasi e ai compiti di CRISP-DM Datascience (basati sulla figura 3 di Chapman, Clinton, Kerber, et al. 1999) come descritto in2.

1 Du Boulay, B., Poulovasillis, A., Holmes, W., Mavrikis, M., Artificial Intelligence And Big Data Technologies To Close The Achievement Gap,in Luckin, R., ed. Enhancing Learning and Teaching with Technology, London: UCL Institute of Education Press, pp. 256–285, 2018.

2 Kelleher, J.D, Tierney, B, Data Science, London, 2018.

3 Hutchinson, B., Smart, A., Hanna, A., Denton, E., Greer, C., Kjartansson, O., Barnes, P., Mitchell, M., Towards Accountability for Machine Learning Datasets: Practices from Software Engineering and Infrastructure, Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, Association for Computing Machinery, New York, 2021.

4 Barocas, S., Hardt, M., Narayanan, A., Fairness and machine learning Limitations and Opportunities, 2022.

5 Schneier, B., Data and Goliath: The Hidden Battles to Capture Your Data and Control Your World, W. W. Norton & Company, 2015.

6 Ethical guidelines on the use of artificial intelligence and data in teaching and learning for educators, European Commission, October 2022.