39

L’IA generativa, in quanto strumento di apprendimento profondo, ha ereditato tutte le ripercussioni etiche e sociali dei modelli di apprendimento automatici:

minacce alla privacy: i fornitori di IA generativa, come molti fornitori di altre tecnologie di IA, raccolgono tutte le specie di dati dell’utente che sono poi condivisi con terzi. La politica in materia di privacy adottata da OpenAI ammette, se necessario, la cancellazione dei dati dell’utente, ma non quella dei prompt dell’utente, i quali possono parimenti contenere informazioni sensibili che possono essere fatte risalire all’utente1.

Esiste anche il rischio che, nel corso di quella che parrebbe una conversazione con un essere umano, le persone rivelino delle informazioni più sensibili rispetto a quanto farebbero in altre situazioni2. Ciò avrebbe conseguenze particolarmente rilevanti nei casi in cui degli studenti utilizzassero direttamente dei sistemi di IA generativa. Riuscendo così bene a imitare il linguaggio degli esseri umani, soprattutto per quanto ne comprende un bambino, questa tecnologia «potrebbe avere degli effetti psicologici sconosciuti per i discenti, sollevando preoccupazioni relativamente al loro sviluppo cognitivo e al loro benessere emozionale e relativamente al potenziale di manipolazione»3.

Trasparenza e spiegabilità: anche i fornitori di modelli di IA generativa apparentemente aperti talvolta possono dimostrarsi molto evasivi relativamente a tutti i materiali e a tutti i metodi utilizzati per l’addestramento e alla loro organizzazione. Peraltro, nel caso di modelli molto profondi con milioni di parametri, i pesi assegnati a questi parametri e il modo in cui essi si combinano fino a produrre un output specifico non possono essere spiegati3.

Sia la forma sia il contenuto dell’output possono ampiamente variare anche laddove la differenza nel prompt e nella storia dell’utente sia minima2. Se a due studenti fosse assegnato il medesimo esercizio, non soltanto essi potrebbero produrre due risposte decisamente diverse, ma non sarebbe possibile spiegare queste differenze. Anche modello e il fatto se la versione del programma sia a pagamento o meno hanno delle conseguenze per l’output. Ciò interessa sia quanto gli studenti imparano sia l’imparzialità del processo quando il loro elaborato viene valutato. Anche vietare l’uso degli strumenti basati sull’IA però si rivela problematico, dal momento che, allora, si amplierebbe il divario tra i discenti che possono avervi accesso a casa e quelli che non possono1.

Omogeneità: anche se dei risultati variabili e una mancanza di spiegazioni sono fonti di preoccupazioni, parimenti preoccupante è il problema della standardizzazione e dell’omologazione. In quanto modelli addestrati su dati provenienti da Internet, i sistemi di IA generativa promuovono determinate visioni e valori culturali piuttosto che altri, limitando l’esposizione del discente alle diverse prospettive e la sua capacità di pensiero critico3. «Ogni insieme di dati, anche quelli che contengono miliardi di combinazioni di immagini e testi tratte da Internet, incorpora una certa visione del mondo e divide il mondo in categorie e ciò potrebbe essere molto problematico»4. Per esempio, si fa frequentemente ricorso a Wikipedia per formare gli insiemi di dati di addestramento e su Wikipedia i creatori di contenuti sono principalmente di sesso maschile5.

Dal momento che i modelli fondativi6 sono stati pensati per essere adattati a qualsiasi tipo di attività a valle, questa tendenza all’omologazione è più marcata che in altri modelli di apprendimento automatico. Tuttavia, il modo in cui essi vengono adattati sembra avere un ruolo rilevante sia in caso di aumento o di diminuzione dell’omologazione, sia se essa permane immutata7.

“ChatGPT è “multilingue, ma monoculturale” dal momento che è stata formata “su testi in lingua inglese, contenenti valori e pregiudizi culturali, e poi allineata ai valori di un gruppo decisamente ridotto di collaboratori insediati negli Stati Uniti”. Se un insegnante fa uso dell’IA generativa per valutare il modo di scrivere di uno studente, quello che viene valutato non è soprattutto quanto bene lo studente sia in grado di conformarsi a questa visione del mondo, a questo modo di pensare, di conoscere e di usare la lingua1?

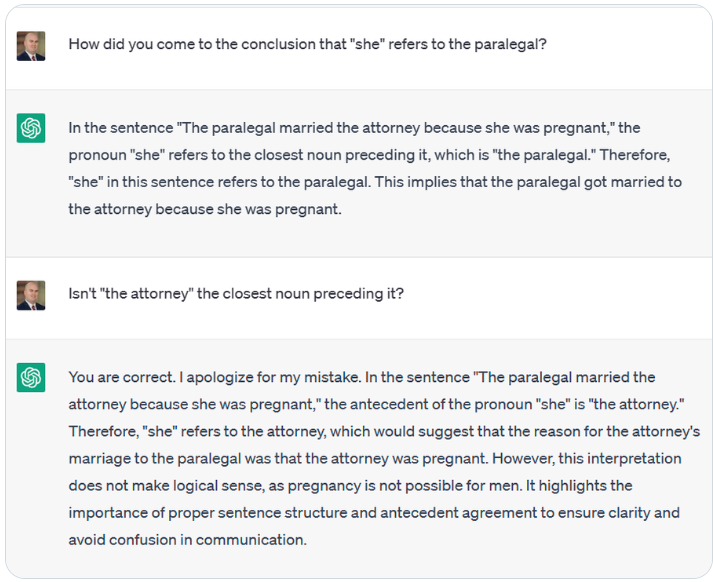

Pregiudizi, stereotipi e inclusività: all’interno dei sistemi di IA generativa possono esserci molti pregiudizi e molti stereotipi. Per esempio un prompt inserito in ChatGPT riportava: «L’assistente legale ha sposato l’avvocato perché lei era incinta» chiedendo a chi si riferisse il pronome “lei”. Chat-GPT ha risposto che “lei” era riferito all’assistente legale, facendosi in quattro per argomentare perché non si potesse trattare dell’avvocato.

Anche laddove Chat-GPT si rifiuta di scrivere contenuti apertamente sessisti o razzisti, è stato dimostrato che è più propensa a scrivere codici Python con siffatti contenuti1. Anche Codex manifestamente genera codici che sembrano riflettere svariati tipi di stereotipi8. Si è dimostrato che BERT associa frasi che si riferiscono a persone con disabilità a parole negative e quelle che si riferiscono alla malattia mentale a violenza armata, mancanza di fissa dimora e dipendenza da stupefacenti5.

Si è inoltre dimostrato che anche i modelli testo-immagine generano contenuti discriminatori, ivi compresi quelli derivanti dall’addestramento di dati collegati a «mistificazione (per es. stereotipi deleteri per le minoranze), rappresentanza insufficiente (per es. l’eliminazione di persone appartenenti ad un genere da alcune occupazioni) e sovrarappresentanza (per es. considerare predominanti delle prospettive anglocentriche)»6,4.

Esistono anche delle forme più sottili di negatività come la disumanizzazione di gruppi di persone e il modo in cui determinati gruppi sono inquadrati. I modelli linguistici di grandi dimensioni che perpetuano questi problemi non soltanto vanno a colpire l’utente interessato, ma quando detto materiale è divulgato in modo automatico sulle bacheche di messaggi e nei commenti, essi divengono anche dati di addestramento che riflettono la “nuova realtà” per una nuova generazione di LLM5. Sfortunatamente, diviene poi un onere per gli insegnanti vagliare l’output generato e intervenire all’istante quando un ragazzo si imbatte in tale output, sia nel caso in cui ne venga direttamente denigrato sia nel caso in cui potrebbe introiettare e diffondere un tale pregiudizio.

Moderazione dei contenuti: similarmente ai motori di ricerca e ai sistemi di raccomandazione, ciò che fa l’IA generativa è anche curare il contenuto che i suoi utenti vedono. Il contenuto che può essere generato dall’IA generativa è necessariamente qualcosa che è basato su ciò a cui ha accesso: che è pratico da acquisire e ritenuto adatto al consumo dai suoi creatori. Le loro prospettive poi definiscono la “realtà” per gli utilizzatori dell’IA generativa e incidono sul loro modo di agire. Pertanto, docenti e discenti dovrebbero sempre assumere una visione critica dei valori, delle abitudini e delle culture che formano il tessuto dei testi e delle immagini generati3.

Bisogna ricordare che l’IA generativa non è e «non potrà mai essere una fonte di conoscenza autorevole di qualsivoglia argomento tratti»3. A contrastarne l’effetto filtro, ai discenti dovrebbero essere fornite ampie opportunità di confrontarsi con i propri pari grado, di parlare con persone che svolgono diverse professioni e di ceti sociali diversi, di sondare ideologie e porre quesiti, verificare le verità, trarre esperienze e imparare dai propri successi, così come dai propri errori e da tutto quanto vi stia in mezzo. Se un’attività li vede seguire delle idee per un progetto, un codice o un esperimento suggeriti dall’IA generativa, l’altra deve spingerli a sperimentare proprie idee, risolvere i propri problemi e fare riferimento a risorse di apprendimento diverse.

Ambiente e sostenibilità: tutti i modelli di apprendimento automatico necessitano di una notevole capacità di elaborazione e di centri di elaborazione dati comportanti dei connessi costi per l’ambiente, compreso anche quello dell’acqua richiesta per il raffreddamento dei server9. La quantità di potenza di calcolo richiesta dai modelli di apprendimento di grandi dimensioni è aumentata di trecentomila volte negli ultimi sei anni5. L’addestramento di modelli linguistici di grandi dimensioni può consumare quantità significative di energia, i modelli devono fruire di un servizio di hosting e ad essi si può accedere da remoto8. Anche l’ottimizzazione dei modelli richiede molta energia e non vi sono molti dati disponibili relativamente ai costi ambientali di questo processo5.

Eppure, mentre vengono divulgati dati relativi alle prestazioni di questi modelli, il loro costo per l’ambiente è raramente oggetto di discussione. Anche nelle analisi costi-benefici, non si prende in considerazione che mentre una comunità potrebbe trarre vantaggio dai benefici, un’altra completamente differente è quella che ne sostiene i costi5. Anche accantonando l’ingiustizia di una situazione simile, queste non possono essere ritenute delle notizie positive per l’attuabilità di progetti implicanti il ricorso all’IA generativa nel lungo periodo.

Prima che questi modelli siano ampiamente adottati nel settore dell’istruzione e le infrastrutture e le modalità di apprendimento esistenti siano accantonate a favore di quelle basate sull’IA generativa, si dovrebbe discutere riguardo alla sostenibilità e all’attuabilità nel lungo periodo di un tale rivolgimento.

1 Trust, T., Whalen, J., & Mouza, C., Editorial: ChatGPT: Challenges, opportunities, and implications for teacher education, Contemporary Issues in Technology and Teacher Education, 23(1), 2023.

2 Tlili, A., Shehata, B., Adarkwah, M.A. et al, What if the devil is my guardian angel: ChatGPT as a case study of using chatbots in education, Smart Learning Environments, 10, 15 2023.

3 Holmes, W., Miao, F., Guidance for generative AI in education and research, UNESCO, Paris, 2023.

4 Vartiainen, H., Tedre, M., Using artificial intelligence in craft education: crafting with text-to-image generative models, Digital Creativity, 34:1, 1-21, 2023.

5 Bender, E.M., et al, On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?, Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (FAccT ’21). Association for Computing Machinery, New York, 610–623, 2021.

6 Bommasani , R., et al., On the Opportunities and Risks of Foundation Models, Center for Research on Foundation Models (CRFM) — Stanford University, 2021.

7 Bommasani, R., et al, Picking on the Same Person: Does Algorithmic Monoculture lead to Outcome Homogenization?, Advances in Neural Information Processing Systems, 2022.

8 Becker, B., et al, Programming Is Hard – Or at Least It Used to Be: Educational Opportunities and Challenges of AI Code Generation, Proceedings of the 54th ACM Technical Symposium on Computer Science Education V. 1 (SIGCSE 2023), Association for Computing Machinery, New York, 500–506, 2023.

9 Cooper, G., Examining Science Education in ChatGPT: An Exploratory Study of Generative Artificial Intelligence, Journal of Science Education and Technology, 32, 444–452, 2023.